Content marketing: l'AI è attendibile? L'importanza delle fonti

“Fidarsi è bene, non fidarsi è meglio”, recita un noto detto popolare. E non vale solo nelle relazioni con le persone: andrebbe seguito un po’ in qualsiasi ambito della vita, e dunque anche quando si utilizza l’intelligenza artificiale generativa.

Questo perché fidarsi ciecamente delle informazioni offerte dalle nuove piattaforme di AI, come ChatGPT, può risultare decisamente pericoloso, e non perché scrivano male o non siano sofisticate.

La ragione è che sono macchine, detto in maniera semplice, e non hanno accesso alla mole di dati sempre necessaria per fare uno studio esaustivo. E non sono un essere umano, pur ponendosi con modalità affini (e quindi facilmente equivocabili).

Oggi non basta più saper scrivere, per raccontare, né tantomeno saper utilizzare gli strumenti più moderni della tecnologia. Si rivela essenziale capire a quali fonti affidarsi, porsi dubbi e domande, confrontare le informazioni che si acquisiscono, verificare e soltanto in ultima analisi scegliere cosa dire.

In un mondo in cui le tempistiche per realizzare dei contenuti sono sempre più rapide, questo processo – che richiede tempo e lavoro – viene sovente messo a dura prova. L’AI può essere di supporto per accelerare il tutto e migliorare la produttività, ma non è attendibile sulle fonti, non pienamente almeno.

Per usarla bene occorrono quindi consapevolezza e professionalità.

Recap su cos’è l’intelligenza artificiale

Ne abbiamo già parlato in diverse altre occasioni ma un recap non guasta mai. Vediamo dunque cosa si intende per intelligenza artificiale, una parola che è diventata ormai parte del lessico quotidiano, ma che spesso viene adoperata in modo improprio e generico.

Pertanto, con tale termine si fa riferimento all'insieme di tecnologia e sistemi che risultano in grado di simulare determinate attività cognitive tipiche dell'essere umano; tra queste troviamo l'analisi, il ragionamento e il problem solving.

L'intelligenza artificiale generativa, questa la denominazione completa della forma maggiormente in uso nel panorama odierno, i programmi sono sviluppati – anche se gli addetti ai lavori utilizzano un termine diverso, ovvero addestrati – su una mole di dati ingenti nell'ottica di conseguire testi che hanno una logica e una coerenza.

I contenuti si dimostrano formalmente ben scritti, rispondenti a domande, in grado di sintetizzare concetti e imitare uno stile conversazionale simile a quello dell'uomo. Trattandosi di macchine, però, questi software, seppur altamente sofisticati, si limitano a produrre dei testi, senza averne reale comprensione.

Cerchiamo di spiegarci meglio con una metafora. Prendiamo uno stabilimento industriale in cui si producono delle lampadine, che sono certamente ben fatte. Peccato tuttavia che la macchina non abbia le capacità di comprenderne l'uso, né parametri che ne stanno all'origine, persino l'effettivo funzionamento.

La stessa cosa avviene con le piattaforme di intelligenza artificiale generativa, solo che trattandosi di testi prodotti attraverso un'interfaccia – e dunque con una relazione più profonda tra uomo e macchina – questo processo è più complesso e difficile da percepire.

Occorre invece ricordarsi ed essere consapevoli che l’AI non sa cosa risulta vero né cosa appare probabile: non sa, produce soltanto.

I numeri di ChatGPT in termini di affidabilità

ChatGPT è la piattaforma più sofisticata – e persino rivoluzionaria potremmo dire, visto che è stata la prima a far parlare di sé – di intelligenza artificiale generativa. Una caratteristica, quest’ultima, che emerge dal suo nome, essendo GPT acronimo di Generative Pretrained Transformer.

Dal 2015 a oggi – ebbene sì, sono già trascorsi dieci anni dal lancio – di strada ne ha fatta parecchia, arrivando a sviluppare un motore di ricerca, ovvero SearchGPT, basato appunto sull'utilizzo dei sistemi di AI generativa.

Disponibile dallo scorso anno, SearchGPT si è proposto come alternativa a Google, che non ha esitato ad aggiornarsi, come confermano i diversi update per quanto riguarda l'algoritmo e non solo.

C'è però da dire che, nonostante gli sforzi fatti dall'azienda americana e dall’effettiva sofisticatezza, SearchGPT non è all'altezza di alcun motore di ricerca non basato esclusivamente sull’AI.

Ciò non è dovuto a un'interazione che appare più intuitiva, immediata e naturale (il suo punto di forza) quanto piuttosto a una questione come quella dell'attendibilità delle informazioni proposte. A parlare chiaro sono i numeri, e vi spieghiamo perché.

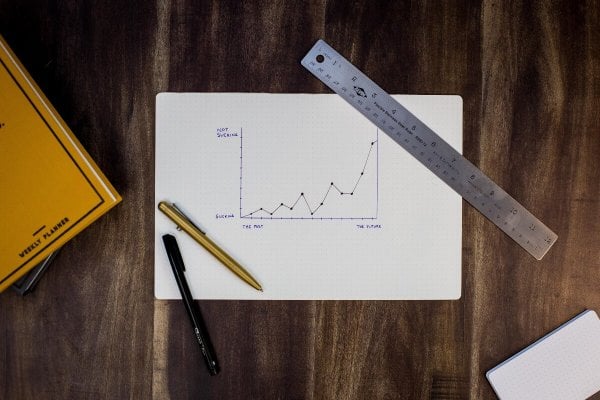

Lo studio della Columbia University, riportato da Wired

Secondo quanto riportato da Wired, che cita a sua volta uno studio del Tow Center for Digital Journalism della Columbia University, nel momento in cui si è sottoposta a SearchGPT una richiesta ben precisa, ovvero di ricercare la fonte da 20 pubblicazioni di 200 citazioni, il motore di ricerca non ha dato risultate all'altezza.

Ecco cosa è emerso:

- Le risposte fornite dalla AI sono risultate ben organizzate e chiare. Sono state elaborate nell’arco di pochissimi secondi.

- Solo poche hanno però offerto informazioni attendibili. Gli accordi sottoscritti da OpenAI con diversi editori non sono stati sufficienti a garantire un'affidabilità dei dati che possa dirsi esaustiva.

- I ricercatori della Columbia hanno inoltre posto l'accento su un altro fattore. ChatGPT è noto per la sua gentilezza spesso percepita come forzata e naturale ma sa essere intransigente, di un’intransigenza che è anch'essa innaturale, agli occhi dell’essere umano. Ricordiamo che entrambi i lati (gentilezza e intransigenza) sono tipici di un sistema che è una macchina: non possono essere davvero naturali, al massimo una valida imitazione. I ricercatori hanno mostrato che il chatbot è persino presuntuoso, quando gli si contesta qualcosa, soprattutto se gli si dice che le informazioni che ha offerto non risultano veritiere o comunque non in linea con la richiesta.

- Su 200 richieste, le risposte completamente errate sono state 89; quelle parzialmente errate 57; quelle completamente corrette 47. ChatGPT ha quindi risposto in maniera valida soltanto in circa un quarto dei casi.

- Soltanto in 7 situazioni il chatbot ha utilizzato un verbo al condizionale manifestando una certa cautela. 7 su 200.

- I numeri, mai come in questo caso, parlano da soli, mostrando quanto risulti importante essere cauti nell'utilizzo dell’AI. Vale sia se la si adopera a livello amatoriale e ancora di più per scopi di natura professionale.

Conclusioni: l’importanza delle fonti e alcune best practices

Bisogna dunque rinunciare a utilizzare ChatGPT, visto che i casi in cui offre informazioni attendibili sono troppo pochi? Assolutamente no: occorre soltanto tutelarsi e adoperare l’AI con le dovute accortezze e dunque con professionalità.

Ecco alcune best practices da adottare:

- È buona prassi fornire al chatbot le fonti da utilizzare per la propria ricerca.

- Appare inoltre imprescindibile sviluppare i contenuti un poco alla volta e relazionandosi con più domande, non limitandosi dunque a una sola.

- È utile mostrare al chatbot il risultato finale realizzato sulla sua base, così addestrarlo in un modo funzionale alle proprie esigenze.

Queste sono solo alcune best practices che i professionisti conoscono bene, ma ce ne sono diverse altre. In ALEIDE WEB AGENCY facciamo molta attenzione alle informazioni che offriamo, in qualsiasi servizio di marketing. Conosciamo e studiamo l’AI, ma la usiamo diffidando, verificando, ricercando le fonti più valide, selezionando. Con professionalità in buona sostanza, e consapevoli dei suoi limiti.